在當今數(shù)據(jù)驅動的決策環(huán)境中,埋點數(shù)據(jù)是理解用戶行為、優(yōu)化產(chǎn)品體驗的基石。從用戶的一次點擊、一次瀏覽到一次購買,這些看似微小的行為都被精心設計的埋點捕獲,轉化為原始數(shù)據(jù)流。原始數(shù)據(jù)本身并無價值,只有經(jīng)過系統(tǒng)化、專業(yè)化的數(shù)據(jù)處理,才能提煉出驅動業(yè)務增長的洞察。本文將探討埋點數(shù)據(jù)的處理流程、核心挑戰(zhàn)與最佳實踐。

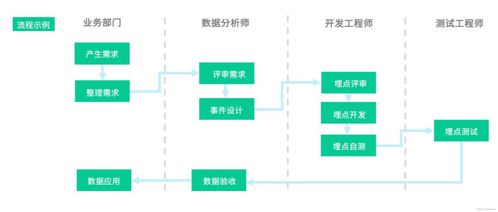

數(shù)據(jù)處理始于埋點方案的嚴謹設計。一個清晰的埋點規(guī)范是后續(xù)所有工作的前提,它需要明確定義每個事件(Event)的名稱、屬性(Properties)以及觸發(fā)時機。例如,“加入購物車”事件應包含商品ID、價格、數(shù)量等屬性。混亂的埋點設計會導致數(shù)據(jù)“臟亂差”,使后續(xù)清洗成本激增。因此,數(shù)據(jù)團隊需要與產(chǎn)品、研發(fā)部門緊密協(xié)作,確保埋點采集的準確性與一致性。

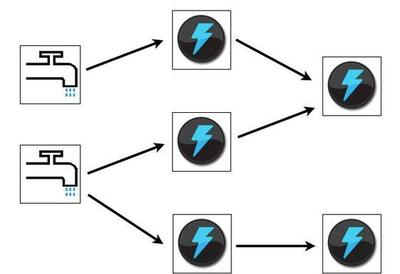

當海量埋點數(shù)據(jù)涌入數(shù)據(jù)管道,數(shù)據(jù)處理的核心階段便隨之展開。這一過程通常包含幾個關鍵步驟:

- 數(shù)據(jù)采集與傳輸:數(shù)據(jù)通過SDK從客戶端(Web、App等)或服務器發(fā)出,經(jīng)由日志收集系統(tǒng)(如Apache Kafka)實時或批量傳輸?shù)綌?shù)據(jù)倉庫(如Hadoop HDFS、云存儲等)。確保傳輸?shù)姆€(wěn)定、低延遲與不丟失是此環(huán)節(jié)的重中之重。

- 數(shù)據(jù)清洗與解析:原始日志通常是半結構化或非結構化的JSON字符串。此步驟需要將其解析、展開,并清洗掉無效數(shù)據(jù)(如空值、測試數(shù)據(jù)、格式錯誤的數(shù)據(jù))。例如,過濾掉內部員工的訪問日志,矯正異常的時間戳。

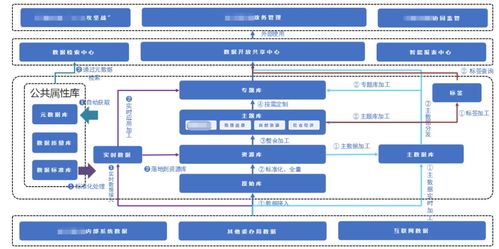

- 數(shù)據(jù)建模與整合:清洗后的數(shù)據(jù)被按照主題(如用戶、商品、流量)組織成易于理解的數(shù)據(jù)模型(如星型模型、維度建模)。這一步將分散的埋點事件與業(yè)務數(shù)據(jù)庫中的用戶信息、商品信息等進行關聯(lián)整合,形成完整的用戶行為旅程視圖。

- 數(shù)據(jù)存儲與計算:處理后的數(shù)據(jù)存入適合分析的數(shù)據(jù)倉庫或數(shù)據(jù)湖(如Snowflake, BigQuery, ClickHouse)。在此之上,通過SQL或大數(shù)據(jù)計算引擎(如Spark, Flink)進行聚合計算,生成每日活躍用戶(DAU)、轉化漏斗、用戶留存率等關鍵指標。

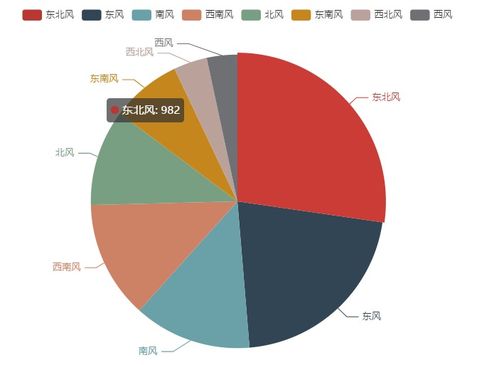

- 數(shù)據(jù)可視化與洞察:數(shù)據(jù)通過BI工具(如Tableau, Looker, 國內如FineBI)以報表或儀表盤的形式呈現(xiàn)給業(yè)務人員。分析師可以基于此進行深度挖掘,回答諸如“新改版功能是否提升了轉化?”等業(yè)務問題。

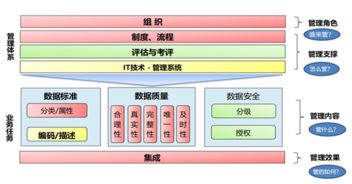

在整個流程中,數(shù)據(jù)質量監(jiān)控與數(shù)據(jù)治理是貫穿始終的生命線。需要建立自動化的數(shù)據(jù)質量校驗規(guī)則,監(jiān)控數(shù)據(jù)量的異常波動、字段取值的分布是否合理,并及時告警。建立統(tǒng)一的數(shù)據(jù)字典和指標口徑,避免“數(shù)據(jù)孤島”和指標歧義。

面對日益復雜的業(yè)務場景和嚴格的隱私法規(guī)(如GDPR、個人信息保護法),數(shù)據(jù)處理也面臨著巨大挑戰(zhàn)。如何在數(shù)據(jù)采集階段做好匿名化與脫敏,如何在數(shù)據(jù)處理流程中確保安全合規(guī),成為技術與管理并重的課題。

埋點數(shù)據(jù)的處理絕非簡單的技術堆砌,而是一個將原始行為“礦石”冶煉成決策“黃金”的系統(tǒng)工程。它要求技術上的嚴謹可靠,更要求對業(yè)務的深刻理解。只有構建起高效、穩(wěn)健、可信的數(shù)據(jù)處理流水線,埋點所蘊含的巨大價值才能真正釋放,成為企業(yè)智能化運營的核心引擎。